Империя NVIDIA под давлением: кастомные AI-чипы меняют правила игры

Уже почти десятилетие NVIDIA остаётся главным двигателем прогресса в сфере искусственного интеллекта. Её графические процессоры лежат в основе ChatGPT, систем автономного вождения и облачных дата-центров по всему миру. Но в 2025 году на горизонте всё отчетливее видны перемены: растущие затраты на энергию, дефицит GPU и потребность в более дешёвых и эффективных решениях делают кастомные AI-чипы, или ASIC, всё более привлекательными.

Чтобы разобраться, как меняется рынок, мы поговорили с Рахулом Сен Шармой, президентом и со-гендиректором компании Indxx, специализирующейся на индексах для технологических отраслей. Он объяснил, почему NVIDIA всё ещё непоколебима, но уже не единственный игрок, и как новая волна кастомных чипов может изменить баланс сил в мире вычислений.

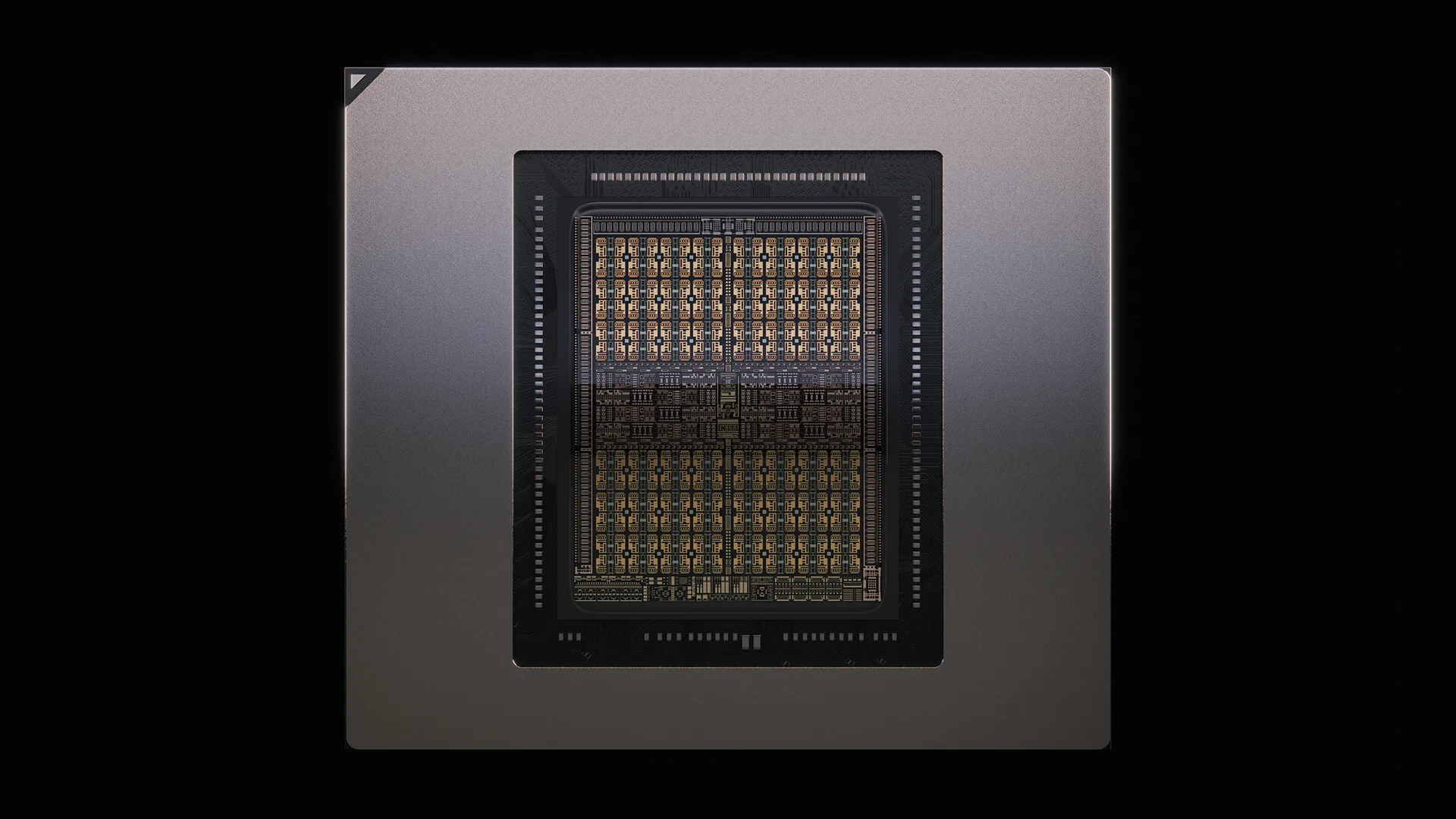

CUDA и Blackwell — ядро современного ИИ

NVIDIA сегодня удерживает около 86% рынка AI-GPU. Её видеочипы серии Blackwell стали стандартом де-факто для обучения и инференса моделей — от OpenAI до автомобильных систем. Главный секрет успеха — программная экосистема CUDA, которая стала универсальным языком для разработчиков ИИ. Благодаря ей NVIDIA удерживает позиции даже в Китае, несмотря на торговые ограничения.

Как отметил Шарма, «сила NVIDIA не только в железе, но и в экосистеме, которая создаёт замкнутый цикл: чем больше разработчиков используют CUDA, тем сложнее конкурентам прорваться». И всё же, как бы ни был прочен этот фундамент, монополия NVIDIA постепенно начинает трещать.

ASIC — новая волна эффективности

На смену универсальности приходит специализация. Гиганты вроде Google, Amazon, Meta и OpenAI создают собственные ASIC — микросхемы, заточенные под конкретные задачи. Эти чипы выполняют меньше функций, но делают это быстрее и с меньшими затратами энергии.

OpenAI сотрудничает с Broadcom над производством собственных ASIC на базе 3-нм техпроцесса TSMC. Они будут использоваться во внутренних дата-центрах компании и не поступят в свободную продажу. Такая стратегия повторяет подход Google с TPU, Amazon с Trainium, Microsoft с Athena и Meta с MTIA: каждая компания строит свою инфраструктуру, чтобы не зависеть от дорогих и ограниченных поставок NVIDIA.

В результате складывается гибридная модель: NVIDIA по-прежнему обеспечивает пик производительности, но всё больше вычислений — особенно инференс — выполняют более дешёвые и энергоэффективные ASIC.

Broadcom — тихий конкурент, который догоняет

Одним из главных претендентов на долю рынка стал Broadcom. Ещё недавно известная в первую очередь как производитель сетевых чипов, компания сегодня активно выходит в AI-сегмент. Только во втором квартале 2025 года её доходы от AI выросли до 4,4 млрд долларов — на 46% больше, чем годом ранее. Партнёрство с OpenAI и покупка VMware позволили Broadcom закрепиться в инфраструктуре крупнейших облачных игроков.

По словам Шармы, «Broadcom становится новым центром силы в AI-аппаратуре. Её стратегия направлена на то, чтобы занять нишу в инференсе, где решающее значение имеют эффективность и стоимость, а не абсолютная производительность». И хотя NVIDIA по-прежнему вне конкуренции по масштабам экосистемы, растущие амбиции Broadcom показывают: монополия не вечна.

Почему «цена за производительность» важнее, чем просто мощность

В эпоху стремительного роста ИИ эффективность становится новой валютой. Дата-центры поглощают колоссальные объёмы электроэнергии и воды, а стоимость владения инфраструктурой растёт быстрее, чем производительность. Amazon, Google, Microsoft и Meta всё чаще выбирают стратегию оптимального баланса — не максимальную мощность, а лучшее соотношение «производительность/стоимость».

Amazon с чипами Trainium добилась того, чего не могла обеспечить даже NVIDIA: полного контроля над вычислительным стеком и сниженных эксплуатационных расходов. Google давно интегрировала свои TPU в сервисы Gemini, Microsoft развивает Athena, а Meta делает ставку на MTIA. Все эти проекты позволяют крупным игрокам меньше зависеть от внешних поставщиков и развивать собственные архитектуры.

Таким образом, эпоха «гонки за максимальной мощностью» уходит в прошлое. Будущее — за оптимизацией, интеграцией и устойчивостью.

Каким будет следующее поколение ASIC

Шарма выделяет несколько направлений, которые определят развитие кастомных чипов:

- Энергоэффективность: Специализированные схемы избегают лишних операций и позволяют экономить до 30% энергии по сравнению с CPU или GPU.

- Безопасность: Новые ASIC получат встроенные средства шифрования и защиту от физического взлома — важный шаг в эпоху кибератак на AI-инфраструктуру.

- Узкая специализация: Каждая задача — свой чип. Это позволяет добиваться рекордной производительности при минимальном энергопотреблении.

- Интеграция с ИИ: Более тесное взаимодействие ASIC с TPU или другими ускорителями позволит использовать AI для анализа данных в реальном времени — от видеообработки до медицины.

- Память нового поколения: С технологиями вроде Compute Express Link (CXL) процессоры смогут обращаться к общим пулам памяти, повышая эффективность работы больших моделей.

Всё это делает ASIC ключевым элементом следующей эры вычислений — умной, энергоэффективной и более защищённой.

Кому выгоден рост рынка ASIC

В выигрыше окажутся почти все участники технологической цепочки. Гиперскейлеры — за счёт независимости. Производители чипов — благодаря новым заказам. А поставщики инфраструктуры — за счёт необходимости обновления дата-центров.

- Гиперскейлеры: Amazon, Google, Microsoft и Meta развивают собственные чипы, снижая зависимость от NVIDIA.

- Производители: TSMC и Samsung продолжают лидировать в производстве, а Broadcom, AMD и Intel активно развивают полукастомные решения.

- EDA-компании: Synopsys, Cadence и Siemens создают инструменты проектирования новых архитектур.

- Производители памяти: Micron, SK Hynix и Rambus адаптируют решения под CXL-платформы.

- Инфраструктура: Vertiv, Schneider Electric и CoolIT Systems разрабатывают передовые системы охлаждения для новых мощностей.

По сути, зарождается новая экосистема, где каждая компания играет свою роль в оптимизации AI-инфраструктуры — от кремния до серверных стоек.

Rubin GPU: когда тепло становится вызовом

На конференции GTC 2025 NVIDIA представила линейку Rubin и Rubin Ultra — самые мощные GPU в своей истории. Но вместе с производительностью пришла и новая проблема: тепло. С каждым поколением плотность мощности в стойках растёт, и традиционное воздушное охлаждение уже не справляется.

«Rubin полностью меняет подход к проектированию дата-центров», — подчеркнул Шарма. «Без жидкостного охлаждения такие системы просто невозможно эксплуатировать».

На этом фоне компании вроде CoolIT Systems и Asetek становятся ключевыми поставщиками решений. CoolIT продемонстрировала новые холодные пластины с технологией Split-Flow, обеспечивающие до 30% лучшую теплопередачу. Vertiv и Schneider Electric создают гибридные инфраструктуры, сочетающие воздушное и жидкое охлаждение, чтобы справиться с тепловыми нагрузками Rubin.

Так охлаждение, когда-то скучная инженерная тема, превращается в стратегическое направление для инвестиций. AI стал не только интеллектуальной, но и физически горячей технологией.

Баланс сил в новом мире ИИ

Позиции NVIDIA остаются мощными, но теперь она не единственная, кто диктует условия. Эра, когда одна компания могла монополизировать весь AI-рынок, уходит в прошлое. Мир вычислений движется к равновесию — между универсальностью и специализацией, скоростью и эффективностью, инновацией и устойчивостью.

Как отметил Шарма, «NVIDIA не исчезнет. Но ей придётся делить сцену с другими».

1 коммент

Битва за AI-железо только начинается, будет жарко во всех смыслах