Foxconn, контрактный гигант, который собирает всё от смартфонов до серверов для гиперскейлов, постепенно превращается в одного из ключевых игроков на рынке AI-инфраструктуры. Последние заказы на стойки, построенные вокруг платформы Google Ironwood TPU, а не только на базе GPU NVIDIA, показывают, что цепочка поставок ИИ начинает осторожно разворачиваться в сторону альтернативных экосистем.

Долгое время дата-центровые GPU NVIDIA казались безальтернативным выбором для обучения и инференса крупных моделей. A100, H100 и их наследники разлетались быстрее, чем партнёры успевали получать квоты, а цены взлетели до уровней, которые даже корпоративным заказчикам приходится проглатывать с трудом. В кулуарах интеграторы шутят, что готовы сотрудничать уже хоть с кем угодно, лишь бы не повторять истории с дефицитом и чёрными экранами, и только AMD традиционно попадает в шутку как вечный аутсайдер. На этом фоне собственные ASIC-системы крупных платформ, вроде Google TPU, перестают быть экспериментом и становятся реальной альтернативой для целых стоек.

По данным тайваньской Economic Daily, Foxconn получила заказы на так называемые compute trays для Google TPU, которые напрямую увязываются с отдельными стойками TPU. Для каждого отправленного шкафа с TPU Google, Foxconn должна отгружать одну стойку с вычислительными лотками – фактически формируя связку 1:1 по всей поставочной цепочке. Параллельно компания будет задействована и в проекте Google Intrinsic по робототехнике, что дополнительно усиливает связку AI-сервера плюс физическая автоматизация на заводах и в логистике.

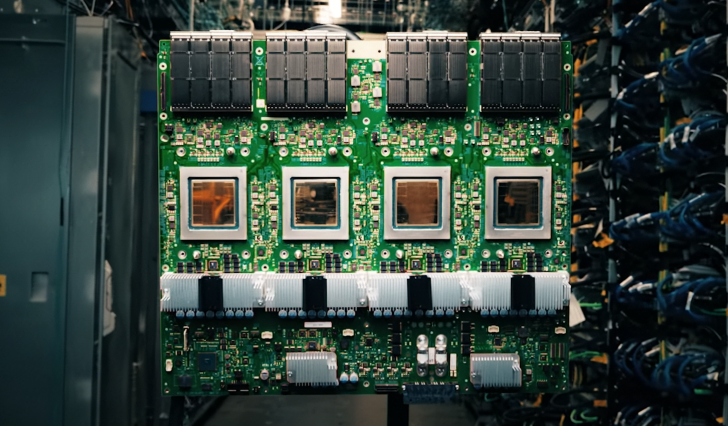

Железо за этим соглашением выглядит впечатляюще не только на бумаге. Седьмое поколение Google TPU, Ironwood, разворачивается в виде так называемых Superpod – заранее спроектированных кластеров, состоящих из до 9 216 чипов в одном поде. В задачах FP8 такой Superpod достигает примерно 42,5 экзафлопс совокупной мощности, а отдельные кристаллы соединяются скоростной шиной InterChip Interconnect. Топология 3D torus позволяет прокладывать короткие маршруты между большим числом чипов, так что весь под работает скорее как единый огромный ускоритель, чем как набор разрозненных плат.

Ключевой момент – это не только пиковая производительность, но и то, как такая архитектура вписывается в реальную экономику ИИ. Обучение базовых моделей остаётся дорогим и громким этапом, но львиная доля затрат всё больше смещается в сторону инференса: бесконечные запросы к ассистентам, поиску, рекомендациям и офисным копилотам. В этих сценариях важнее не рекордные бенчмарки, а предсказуемая задержка, энергоэффективность и итоговая стоимость владения. ASIC-подход, к которому относятся TPU и другие NPU, позволяет отказаться от лишней графической логики, блоков растеризации и прочего наследия видеокарт, сосредоточившись на матричной арифметике, памяти и межсоединениях.

Google последовательно развивает именно эту философию: полный контроль над стеком от микросхем и топологии стойки до компиляторов и облачного софта. NVIDIA, в свою очередь, тоже шаг за шагом избавляла серверные GPU от типично игровых блоков ещё с эпохи A100, но ей приходится учитывать интересы множества клиентов и сценариев использования. Разница в том, что TPU Superpod создаётся как максимально закрытый, но очень цельный продукт: вы покупаете не набор компонентов, а заранее выстроенную фабрику для ИИ-нагрузок, и Foxconn здесь выступает тем, кто превращает чертежи Google в серийное железо.

Давление усиливает и вопрос цен. В профессиональном сообществе давно ворчат, что в каждом счёте на серверы с NVIDIA далеко не вся сумма уходит в реальные компоненты и исследования, а дефицит и премии за бренд давно превратились в бизнес-модель. Гиперскейлы вроде Google, напротив, прямо заинтересованы в том, чтобы снижать стоимость одного запроса по мере роста нагрузки: чем дешевле инференс, тем выгоднее масштабировать сервисы. Агрессивное продвижение TPU и расширение производственных контрактов с Foxconn выглядят логичным шагом в этой стратегии.

Конечно, мемы в духе «всё, NVIDIA закончилась» по-прежнему собирают лайки, но реальность сложнее. CUDA-экосистема, гигантский стек библиотек, привычные инструменты для дата-сайентистов и MLOps-команд никуда не денутся за одну-две продуктовые линейки. GPU остаются самым гибким вариантом для смешанных нагрузок, исследований и тех компаний, которые не готовы запираться в одном облаке. Но у рынка окончательно пропало желание жить в мире, где есть только один поставщик ключевого железа, и заказы Foxconn на стойки с TPU – наглядный признак того, что крупные заказчики активно выстраивают вторые и третьи источники мощности.

В долгосрочной перспективе роль Foxconn как нейтрального сборщика может оказаться не менее важной, чем логотипы на самих чипах. Если будущее AI-инфраструктуры – это пёстрый зоопарк из GPU, TPU и других ускорителей, то кто-то должен превращать все эти кристаллы в надёжные, ремонтопригодные стойки, которые можно быстро масштабировать по всему миру. Новые заказы на Superpod для Google показывают, что Foxconn рассчитывает быть в самой середине этой многовендорной эпохи, а доминирование NVIDIA впервые сталкивается не с теоретическими, а с вполне осязаемыми вызовами со стороны кастомного кремния Big Tech.

1 коммент

42 экзафлопса в одном поде… народ, сколько флопсов вообще надо, чтобы наша железка официально перешла в режим цифрового божества? 🤖🔥