AMD выводит на орбиту сразу нескольких клиентов масштаба OpenAI: что это меняет для Instinct и всего рынка ИИ

AMD больше не строит стратегию вокруг одного-единственного громкого контракта. На последнем отчётном звонке Лиза Су подчеркнула: компания готовит несколько проектов, сопоставимых по масштабу с OpenAI. Для рынка это сигнал зрелости: спрос на ускорители Instinct формируется не одиночными покупками «карт в стойку», а программами развёртывания целых дата-центров с поэтапной поставкой стоек, сервисным сопровождением и совместной инженерией.

Что подразумевается под «масштабом OpenAI» на практике? Это многолетние планы на мощности в разных регионах, собственные ряды стойко-комплектов, согласованные графики обучения моделей и сервисные SLA по инференсу. Главная мысль: AMD стремится к повторяемым шаблонам поставок — не к штучным проектам, которые сложно тиражировать.

Дорожная карта Instinct: MI355 набирает темп, MI450 намечен на H2

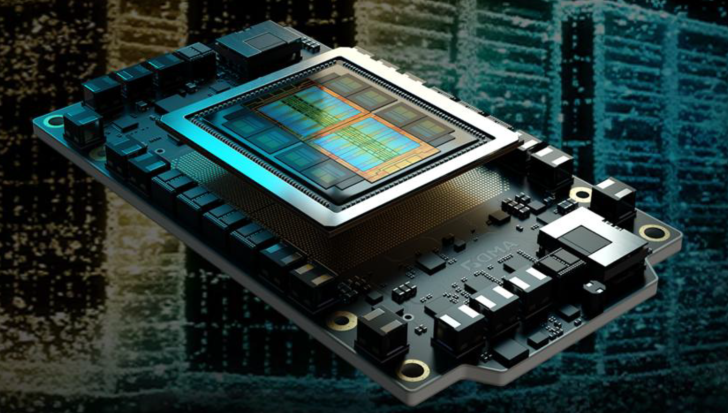

Под эту логику подведена и продуктовая линия. Производство семейств Instinct MI355 уже на подъёме, импульс ожидается и в 2026 году. Следующая веха — серия Instinct MI450, выход которой запланирован на вторую половину следующего года. В фокусе — скачок по производительности на ватт, ёмкость и пропускная способность памяти, а также стойко-уровневая плотность. Всё это напрямую влияет на совокупную стоимость владения для тренировочных кластеров и ферм инференса.

Повышенная энергоэффективность — не абстракция. Если MI450 даст больше устойчивого вычислительного «тела» в том же энергетическом бюджете, операторы смогут нарастить число обучаемых токенов и обслуживаемых запросов без переделки энергетики зала. Важный акцент AMD — поставка не «железа по частям», а готовых стоек: ускорители, CPU, сеть, охлаждение, управление — как единая система. Это ускоряет ввод мощностей и снижает риски интеграции.

Софт против гравитации CUDA: ставка на ROCm и мультивендорность

Сколько бы ни говорили о терах и ваттах, исход сражения часто решает софт. Экосистема CUDA десятилетиями накапливала оптимизации; многие библиотеки PyTorch и TensorFlow полагаются на неё. Ответ AMD — ROCm с агрессивной работой над компиляторами, ядрами и апстримом фреймворков. Крупным заказчикам предлагается прагматичный маршрут портирования, закрываемый вендорскими инструментами и выделенными инженерами. Для операторов, строящих парк из нескольких вендоров, это страховка против дефицита поставок и ценовой монополии.

Зачем AMD несколько «мега-заказчиков»

Фраза Су о планах на «нескольких клиентов масштаба OpenAI» — ещё и про риски. Сверхконцентрация на одном гиперскейлере делает выручку хрупкой: любое изменение приоритетов бьёт по прогнозам. Распределённый портфель сглаживает спрос и укрепляет позицию AMD при распределении дефицитных мощностей продвинутой упаковки. Если Instinct будет входить сразу в несколько гигантских парков, да ещё со сдвинутыми по времени волнами, рост станет предсказуемее.

Чего ждать дальше

- Реальная пропускная способность: скорость обучения (tokens/sec) и стабильность инференса на продакшен-стэках.

- Perf/W и плотность: даст ли MI450 возможность нарастить вычисления без новых вводов по питанию и охлаждению.

- Зрелость ROCm: «мягкая посадка» привычных воркфлоу в PyTorch/TF и совместимость со сторонними библиотеками.

- Поставки без «бумажных релизов»: синхронность графиков для нескольких крупных клиентов одновременно.

В идеальном сценарии рынок ЦОД ИИ эволюционирует из спринта одного вендора в марафон с несколькими сильными участниками. Если AMD подтвердит обещания по стойкам и софту, вопрос «может ли она конкурировать» сменится на «как быстро операторы вольются в мультивендорный ритм без боли по процессам и людям».

Вывод: AMD удваивает ставки на ИИ — от архитектуры до поставки стоек и структуры клиентской базы. MI355 уже разгоняется, MI450 — ориентир на H2. При удачной комбинации эффективности и зрелости софта словосочетание «масштаб OpenAI» перестанет быть лозунгом и станет рабочей метрикой для контрактов Instinct в самом сердце ИИ-инфраструктуры.