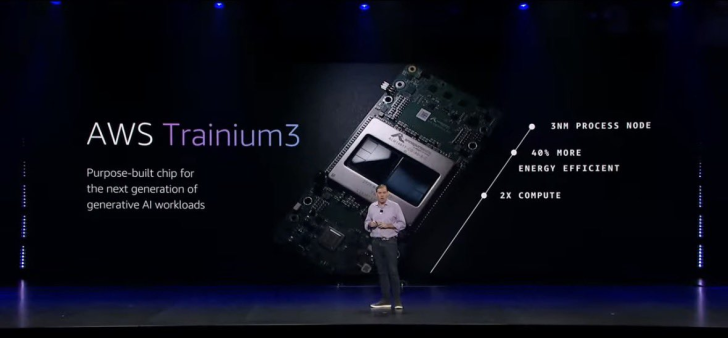

Amazon больше не хочет быть просто облачным провайдером, который сдаёт в аренду чужие GPU. Компания стремительно превращается в полноценного разработчика чипов для искусственного интеллекта, выстраивая собственную линейку специализированных ASIC. На конференции AWS re:Invent 2025 именно кастомные ускорители стали главным номером программы: Amazon показала мощные серверы на базе Trainium3 и приоткрыла завесу над следующей генерацией — чипами Trainium4.

Контекст здесь важен. Вся индустрия сейчас живёт в режиме гонки вооружений: Google развивает TPU, Meta проектирует свои ИИ-ускорители, Microsoft делает ставку на чипы Maia. На этом фоне Trainium — ответ Amazon на растущий спрос на генеративный ИИ, обучение гигантских языковых моделей и работу с невероятно тяжёлыми датасетами, где классические GPU уже упираются в лимиты по стоимости, доступности и энергопотреблению.

Центральная новинка — системы Trainium3 UltraServers. Это не просто набор отдельных серверов, а цельно интегрированная платформа, в которой может работать до 144 чипов Trainium3 в одном кластере. По заявлению Amazon, такая конфигурация обеспечивает до 4,4 раз больше вычислительной мощности по сравнению с Trainium2 UltraServers, примерно четырёхкратный рост энергоэффективности и почти четырёхкратное увеличение пропускной способности памяти. Для разработчиков ИИ это означает возможность запускать модели заметно крупнее и обучать их ощутимо быстрее.

На практике это выглядит так: обучение, которое раньше растягивалось на месяцы, можно ужать до нескольких недель. Цикл экспериментов с архитектурами и гиперпараметрами сокращается, а выход на продакшн ускоряется. После обучения те же UltraServers можно использовать для инференса, одновременно обслуживая гораздо больше запросов пользователей и заметно снижая стоимость каждого ответа, текста, изображения или кода, который генерирует модель.

Ключевая технологическая фишка Trainium3 UltraServers — новая межсоединительная технология NeuronSwitch-v1. По сути, она играет роль, похожую на NVLink у NVIDIA, но реализована силами Amazon и полностью заточена под масштабирование Trainium-кластеров. По данным AWS, NeuronSwitch-v1 позволяет объединить до миллиона чипов Trainium в единую систему. На таком уровне можно говорить о работе с триллионными токен-дискретами и моделями, которые раньше существовали лишь на слайдах презентаций.

Важно, что речь идёт не только о «красивых цифрах» для слайдов. Современные языковые модели чувствительны к объёму и качеству данных, а также к тому, насколько быстро память и сеть могут подать эти данные на вычислительные блоки. Высокоскоростная связность и широкая полоса памяти уменьшают простои ускорителей, повышают реальную загрузку и позволяют достигать большей точности и стабильности обучения при сопоставимых бюджетах.

Отдельно стоит отметить энергоэффективность. Четырёхкратное улучшение по этому параметру не только снижает счета за электричество и охлаждение, но и делает масштабирование инфраструктуры более предсказуемым. В условиях, когда многие компании упираются в лимиты по мощности датацентров, каждые дополнительные проценты эффективности переводятся в десятки и сотни новых моделей, которые можно запустить без строительства ещё одного ЦОДа.

Появление UltraServers на базе Trainium3 также сигнализирует о более широком тренде: производители ASIC стремятся расширить портфели, чтобы снизить зависимость рынка от дефицитных и дорогих GPU. Amazon, имея под контролем и облако, и чипы, и программный стек, может предложить клиентам более гибкие конфигурации и оптимизации под конкретные задачи — от классического обучения до сложных сценариев мультимодального инференса.

Следующий шаг — Trainium4. Amazon уже поделилась некоторыми характеристиками будущих чипов: ожидается до 6 раз более высокая производительность в FP4-режиме и существенный рост объёма и скорости памяти. Это особенно важно для огромных языковых моделей и архитектур типа mixture-of-experts, где низкая разрядность вычислений и эффективная работа с памятью напрямую определяют финальную стоимость владения.

Самый интересный момент для многих клиентов — поддержка NVIDIA NVLink в Trainium4. Это открывает путь к гибридным кластерам, где в рамках одного решения сосуществуют Trainium и GPU NVIDIA. Компаниям не придётся с нуля перестраивать весь парк оборудования: можно постепенно добавлять Trainium в уже существующие NVLink-кластеры, комбинируя привычный CUDA-стек с преимуществами собственных чипов AWS по цене и эффективности.

Amazon подчёркивает, что внешний интерес к её ИИ-чипам уже велик. В качестве одного из примеров приводится Anthropic, которая сообщает о заметном снижении затрат на обучение при использовании Trainium. Для провайдеров крупных моделей, стартапов и корпораций, уставших от дефицита GPU и ценовых качелей, такие кейсы звучат весьма убедительно: можно остаться в экосистеме AWS, но при этом получить более предсказуемую экономику и дорожную карту развития железа.

В итоге мы наблюдаем важный сдвиг в облачной индустрии. Крупные платформы перестают быть только арендаторами чужих чипов и всё активнее превращаются в вертикально интегрированных игроков, которые сами проектируют кремний, сети и системы сверху донизу. С выходом Trainium3 UltraServers и анонсом Trainium4 Amazon фактически заявляет, что намерена быть одним из лидеров в мире кастомных ASIC для ИИ и активно формировать будущее вычислений, а не просто подстраиваться под него.

2 комментария

Чувствую, скоро AWS будут продавать не только облако, но и свои чипы геймерам шутка… пока что 😉

Anthropic экономит на обучении, а я всё ещё коплю на одну 4070, жизнь боль 😅