Дорожная карта AMD Instinct MI400 и MI500: реальный вызов доминированию NVIDIA в ИИ

Всего за пару лет ускорители для искусственного интеллекта превратились из нишевых карт для дата-центров в самый дефицитный и желанный тип чипов в индустрии. Сегодня лидер очевиден: NVIDIA с её Hopper, Blackwell и будущей линейкой Vera Rubin практически монополизировала рынок. Но AMD больше не хочет оставаться вечным догоняющим. На Financial Analyst Day 2025 компания показала понятную, агрессивную дорожную карту Instinct MI400 и MI500 и ясно дала понять, что собирается бороться за каждую стойку в современном ИИ-центре обработки данных.

Ключевая идея AMD проста: вместо редких громких релизов перейти к предсказуемому ежегодному циклу обновления Instinct, примерно так же, как это делает NVIDIA. Уже вышедшие ускорители CDNA 3 и CDNA 4, такие как Instinct MI300X, MI325X и MI350X, открыли AMD двери в крупные облака и суперкомпьютерные центры. Теперь же в строю появляются два следующих шага: Instinct MI400 на архитектуре CDNA 5, запланированный на 2026 год, и Instinct MI500 на следующем поколении архитектуры, ожидаемый в 2027 году. Вместе они должны превратить AMD из «второго варианта» в полноценную альтернативу для гиперскейлеров, государственных структур и крупных корпоративных клиентов.

Instinct MI400: CDNA 5, HBM4 и упор на стойки для ИИ

Линейка Instinct MI400 станет главным оружием AMD в 2026 году. Она основана на архитектуре CDNA 5 и не выглядит простым косметическим обновлением по сравнению с MI350. Согласно официальным цифрам, флагман MI400 рассчитан примерно на 40 петафлопс при FP4 и 20 петафлопс при FP8, то есть почти вдвое мощнее MI350 по чистой вычислительной производительности. Такой запас даёт возможность обслуживать всё более тяжёлые языковые и мультимодальные модели, не упираясь сразу же в ограничение по скорости или энергопотреблению.

Но одними флопсами современные модели не насытишь. Настоящая изюминка MI400 — подсистема памяти. AMD переходит на HBM4, увеличивая объём памяти с 288 ГБ HBM3e у MI350 до внушительных 432 ГБ на каждый ускоритель. Это примерно плюс 50 процентов к ёмкости. Одновременно заявляется и резкий рост пропускной способности — до 19,6 ТБ/с, что более чем вдвое превосходит уровень MI350. Для гигантских языковых моделей, которые всё чаще насчитывают сотни миллиардов параметров, такое сочетание объёма и скорости критично: чем больше весов помещается на один GPU, тем меньше приходится резать модель на фрагменты и терять эффективность на коммуникациях.

Не забыто и масштабирование за пределы одного ускорителя. AMD говорит о приблизительно 300 ГБ/с масштабируемой межсоединительной полосы на GPU, что важно для кластеров, где десятки и сотни ускорителей работают как единое целое. Дополнительный акцент делается на стандартных решениях для сетей стойочного уровня — UALoE, UAL, UEC. В переводе с инженерного на человеческий это означает, что AMD хочет встроиться в уже существующую инфраструктуру дата-центров, а не навязывать закрытую, полностью проприетарную экосистему, за которую придётся платить втройне.

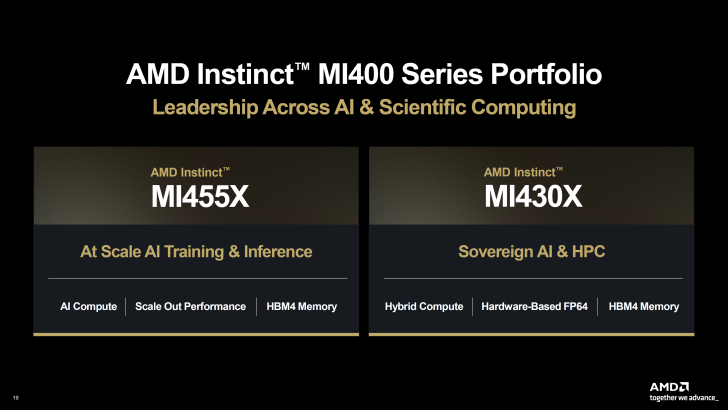

MI455X и MI430X: два лица семейства MI400

Внутри серии MI400 AMD выпускает как минимум два чётко разделённых продукта. Instinct MI455X — это топовая конфигурация для масштабного обучения и высокоплотного инференса. Именно на него будут смотреть облачные провайдеры и крупные ИИ-платформы, когда нужно упаковать как можно больше моделей в одну стойку и при этом сохранить запас по объёму памяти под будущие версии сетей. Полный набор возможностей CDNA 5 и HBM4 объёмом 432 ГБ делают MI455X прямым конкурентом NVIDIA Vera Rubin в самых жирных заказах.

Instinct MI430X нацелен на несколько иной сегмент. Это история про классический HPC и так называемый суверенный ИИ, когда государствам, исследовательским центрам и большим корпорациям нужна производительная, но при этом строго контролируемая инфраструктура под собственные модели и научные задачи. Здесь на первый план выходят высокая производительность в FP64, тесная связка CPU и GPU и тот же большой объём HBM4. AMD явно предлагает MI430X как строительный блок для суперкомпьютеров, где на одном железе живут и климатические симуляции, и национальные языковые модели, и чувствительные отраслевые датасеты.

Сравнение с NVIDIA Vera Rubin: не только гонка флопсов

На уровне презентаций AMD выглядит уверенно. Компания заявляет примерно полуторакратное преимущество по объёму памяти относительно сопоставимых решений конкурентов, сопоставимую пропускную способность памяти, равный уровень производительности в FP4 и FP8, сопоставимую масштабируемость внутри узла и около полуторакратного преимущества по межузловой полосе связи. Если эти цифры подтвердятся на реальных образцах, многие клиенты потеряют удобное оправдание в духе «ну у NVIDIA же просто всё лучше на бумаге».

Однако инженеры, которые уже строили крупные кластеры, хорошо знают: модели обучают не таблицы спецификаций, а законченные системы. Как метко подмечали комментаторы, дело не только в том, чей отдельный GPU быстрее, а в том, кто умеет масштабироваться до целых фабрик ИИ. NVIDIA уже продемонстрировала это на практике, продавая не чипы, а полностью продуманные «AI factories» с сетью, ПО и сервисами. AMD только подходит к этой планке и пытается доказать, что связка MI400, HBM4, стандартных интерконнектов и развивающегося стека ROCm может дать сопоставимый масштаб без жёсткой привязки к одному вендору.

MI500 в 2027 году: следующий уровень после MI400

Если MI400 — это заявка на серьёзное участие в гонке уже в ближайшие годы, то семейство Instinct MI500 — более дальний и более амбициозный выстрел. Подробностей пока немного, но AMD уже говорит о следующем поколении архитектуры CDNA Next или UDNA, переходе на новый техпроцесс и существенном росте вычислительной плотности, памяти и межсоединений. MI500 позиционируется как основа для полностью «нового поколения» стоек ИИ, а не как простой модуль замены в существующих системах.

Фанаты и аналитики, разумеется, уже строят свои теории: кто-то ждёт условный MI450X на более продвинутом техпроцессе, чем 3 нм у Vera Rubin, кто-то уверенно пишет, что именно MI500 станет моментом истины для баланса сил на рынке. Можно относиться к этим ожиданиям скептически, но сам факт, что разговор идёт не о том, «догонит ли AMD хоть чуть-чуть», а о возможном преимуществе в ряде метрик, показывает, как сильно изменилась картина за последние несколько лет.

Геймеры, ИИ и страх остаться за бортом

На фоне миллиардных контрактов в дата-центрах отдельная аудитория смотрит на всё это с куда меньшим энтузиазмом. Речь о геймерах, которые видят, как глава AMD Лиза Су всё больше говорит об ИИ и серверных ускорителях и почти не упоминает десктопные карты Radeon. В комментариях регулярно звучит мысль, что под Instinct и EPYC уходят и лучшие техпроцессы, и лимитированные квоты на выпуск, а геймеры получают лишь крохи.

Реальность, как обычно, сложнее. Да, именно ИИ-ускорители сейчас приносят наибольшую маржу, и оба больших игрока логично ставят на них приоритет. Но технологии, появляющиеся в Instinct, не запираются навсегда в дата-центрах. Пакетирование с HBM, новые схемы питания, переработанные кэш-иерархии и продвинутые межсоединения рано или поздно просачиваются в игровые и профессиональные GPU. Уже озвученные планы AMD на вторую половину десятилетия, включая будущие игровые архитектуры, завязаны на общую эволюцию CPU и GPU. Так что у геймеров скорее пауза, чем окончательный приговор, а пока именно ИИ-буйство оплачивает разработку будущих поколений Radeon.

Пузырь или новая норма для индустрии

Наконец, над всей этой гонкой нависает вопрос, который часто задают и инвесторы, и обычные пользователи: а не ИИ ли это пузырь. Парадоксально, но многие из тех, кто громче всех высмеивал «ИИ-манию» пару лет назад, сегодня нервно обновляют новости о новых GPU и дорожных картах. На фоне этого звучит популярная шутка, что если пузырь и лопнет, то больнее всего ударит по NVIDIA, слишком плотно привязанной к одному сегменту, тогда как AMD по-прежнему распределяет усилия между консолями, ПК, встраиваемыми решениями и серверными CPU.

AMD, судя по всему, не верит в скорое затухание спроса. Никто не вкладывается в ежегодный цикл ускорителей, HBM4 и новую архитектуру межсоединений, если уверен, что через пару лет всё схлопнется. Гораздо более реалистичный сценарий — замедление роста и жёсткое требование со стороны клиентов к диверсификации поставщиков. Крупным игрокам всё сложнее оправдывать ставку на одного вендора с почти монопольным ценообразованием. Именно это окно и пытаются занять Instinct MI400 и MI500.

Итог: презентации сегодня, настоящая конкуренция завтра

Сейчас MI400 и MI500 существуют в основном в виде слайдов, целевых показателей и аккуратно подобранных диаграмм. Настоящая битва начнётся, когда инженерные образцы попадут в лаборатории и пилотные кластеры и им придётся столкнуться с зрелой экосистемой NVIDIA, включая программное обеспечение, библиотечки, инструменты оркестрации и отлаженные референс-системы. AMD предстоит доказать, что Instinct может предложить не только привлекательный набор цифр, но и устойчивые, масштабируемые кластеры, предсказуемые сроки поставок и комфортную среду для разработчиков.

Если это удастся, выигрыш будет огромным — и не только для самой AMD. Более ёмкие по памяти ускорители MI455X и MI430X дадут рынку настоящую архитектурную альтернативу там, где сегодня по привычке выбирают зелёный логотип. MI500 способен усилить конкуренцию ещё сильнее, влияя не только на цены, но и на темп инноваций. В результате главный вопрос «эры ИИ» звучит уже не как «кто сделает самый быстрый GPU», а как «останется ли рынок заложником одного игрока или превратится в действительно конкурентную среду». AMD наконец вошла на ринг. В ближайшие годы станет понятно, сможет ли она превратить несколько точных ударов в полноценный равный бой.

2 комментария

Так, подождите, ещё вчера половина чата писала «ненавижу ИИ пузырь», а сегодня те же люди спорят, будет ли MI450X на 2 нм. Люди вообще определиться могут или нет? 😂

Про «пузырь ИИ» смешно, вчера все ныли что это хайп, сегодня спорят какой 40 PFLOPS ускоритель выгоднее взять. Такое чувство, что пузырь лопнет только для кошелька, а не для рынка 🤣