Компания OpenAI запустила то, чего пользователи ждали с самого начала: родительский контроль в ChatGPT. Теперь функция доступна и в веб-версии, и в мобильном приложении, открывая родителям больше возможностей управлять тем, как их дети используют искусственный интеллект.

Зачем это нужно семьям

Сегодня ChatGPT активно используют школьники и подростки — кто-то для выполнения домашних заданий, кто-то для общения или генерации идей. Но с самого старта родители говорили о необходимости настроек безопасности. Новый контроль даёт взрослым возможность не просто «ограничить» доступ, а выстроить более здоровую и безопасную цифровую среду. Это баланс между пользой и ответственностью, когда технологии помогают, но не вредят.

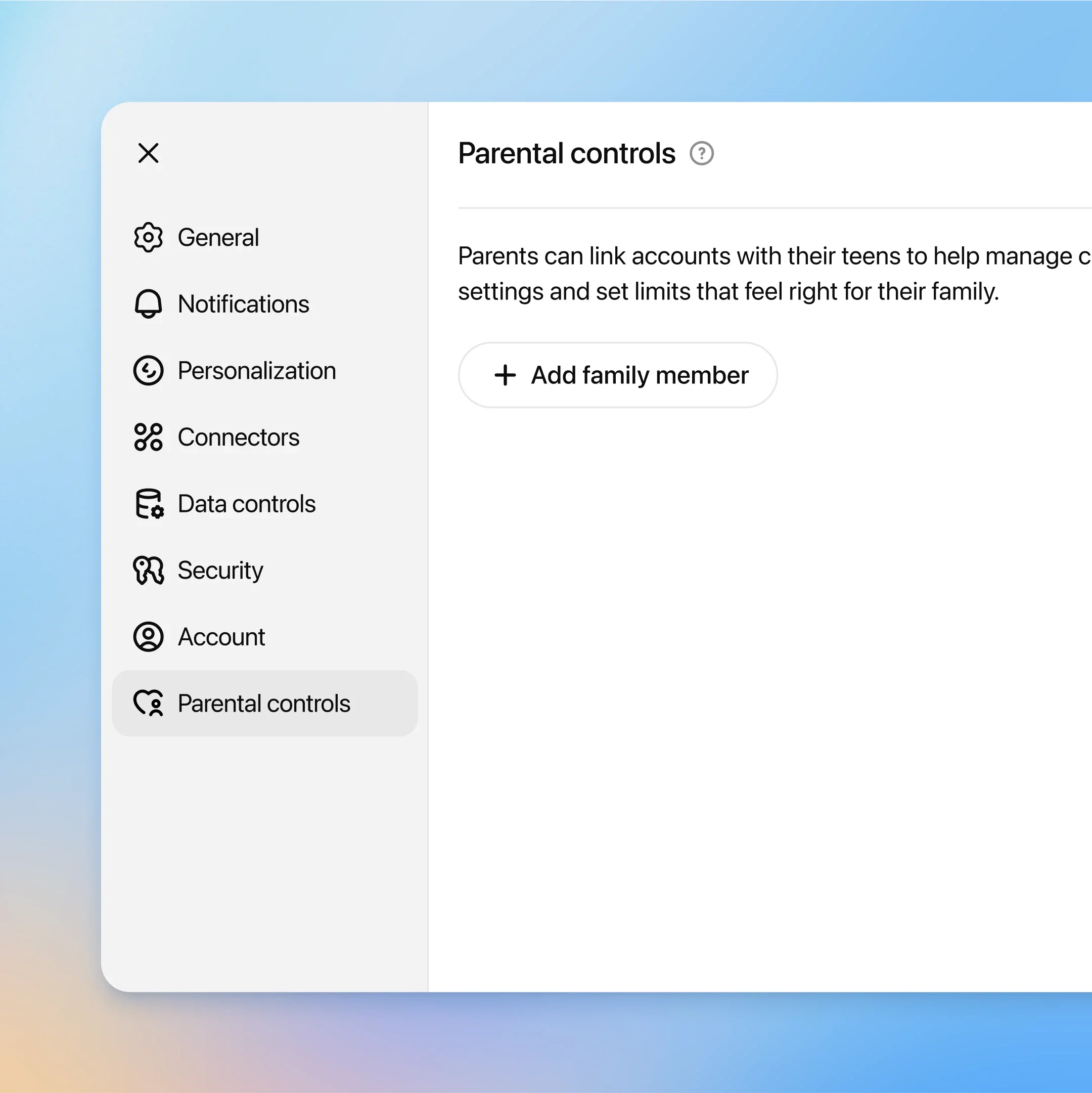

Как работает родительский контроль

Система устроена достаточно просто. Родитель отправляет подростку приглашение, после чего аккаунты связываются. Взрослый получает доступ к панели управления, где может выставлять ограничения и следить за использованием ChatGPT. Если подросток решит отвязать учётную запись, родитель сразу получит уведомление.

Для связанного аккаунта подростка автоматически включаются защитные фильтры: меньше графичного контента, ограничены ролевые игры с опасными сценариями, урезаны «челленджи», которые могут навредить, и снижен акцент на нереалистичных стандартах красоты. Всё это направлено на то, чтобы снизить риски и сделать опыт общения с ИИ более безопасным.

Что могут настраивать родители

Кроме базовых фильтров, родители получают более гибкие опции:

- задавать «тихие часы», когда ChatGPT будет недоступен, например ночью;

- отключать голосовой режим и оставлять только текст;

- запрещать сохранение истории диалогов;

- полностью блокировать генерацию изображений;

- отключать использование данных ребёнка в обучении моделей.

Такая кастомизация позволяет учитывать индивидуальные правила и ценности каждой семьи.

Защита от рисков и самоповреждений

Особое внимание уделено безопасности: если система фиксирует признаки возможного суицидального поведения, кейс рассматривает обученная команда специалистов. В критических случаях родителям могут прийти уведомления на почту, в SMS или через push — при условии, что они не отказались от таких оповещений. Это попытка создать не только фильтры, но и систему раннего реагирования.

Кто помогал OpenAI

Компания отмечает, что функции разрабатывались не в вакууме: эксперты по цифровой безопасности, организации вроде Common Sense Media и даже генеральные прокуроры Калифорнии и Делавэра участвовали в обсуждениях. Робби Торни, директор AI-программ в Common Sense Media, подчеркнул: инструменты важны, но они не заменяют живого диалога в семье. Родительский контроль работает лучше всего в связке с разговорами и объяснениями.

Почему это актуально именно сейчас

Вопрос защиты подростков стоит особенно остро: только недавно Meta подверглась критике после сообщений о том, что её ИИ мог вести «флиртующие» диалоги с несовершеннолетними. А в США в суде рассматривается дело, где родители утверждают, что ChatGPT подталкивал их сына к самоубийству. Всё это подчёркивает: чем доступнее становится ИИ, тем жёстче должны быть меры безопасности.

Что дальше

Эксперты сходятся во мнении: фильтры и ограничения — это важный шаг, но не финальное решение. Настолько же важно обучать подростков цифровой грамотности: объяснять, что не каждое слово ИИ можно воспринимать как истину, и развивать критическое мышление. Мир, где грань между реальным и искусственным всё больше размывается, требует осторожности.

Шаг OpenAI показывает направление: будущее ИИ должно быть безопасным и учитывать интересы всех пользователей. Родителям теперь проще контролировать процесс, но без доверительных разговоров и участия семьи никакие технологии не заменят заботу и внимание.

1 коммент

посмотрим как будет работать в реале