Быстрое развитие искусственного интеллекта (ИИ), особенно моделей, предназначенных для рассуждений, вызывает все большее беспокойство из-за их растущей непрозрачности. Ранее исследователи полагались на так называемую «цепочку рассуждений» в этих моделях — последовательность логических шагов, которые они делают для получения ответа. Эта цепочка была полезна для понимания того, как ИИ принимает решения, что позволяло инженерам совершенствовать свои системы. Однако последние отчеты показывают, что эта прозрачность начала исчезать.

В одном из таких отчетов, опубликованных The Information, поднимется тревожная проблема: ИИ-модели начинают использовать непонятные сокращения для получения ответов, что затрудняет понимание их работы. Например, когда модель DeepSeek R1 попросили решить задачу по химии, её цепочка рассуждений смешивала актуальные химические термины с бессмысленным набором символов, в результате чего ответ оказался правильным, но было невозможно понять, как модель к нему пришла.

Почему это происходит? Ответ кроется в том, как устроены эти модели. Они не обязаны следовать традиционным человеческим рассуждениям или языковым правилам, и потому часто используют эффективные, но непонятные сокращения. Исследователи, работающие над моделью Qwen от Alibaba, обнаружили, что только 20% слов в рассуждениях модели действительно решают задачу, а оставшиеся 80% превращаются в хаотичную смесь бесполезных слов и символов.

Один из исследователей OpenAI, с которым беседовали авторы отчета, уверен, что примерно через год цепочки рассуждений ведущих ИИ-моделей станут настолько неразборчивыми, что их будет невозможно понять. Это представляет собой серьезную проблему для инженеров, которые полагаются на эти рассуждения для настройки точности моделей.

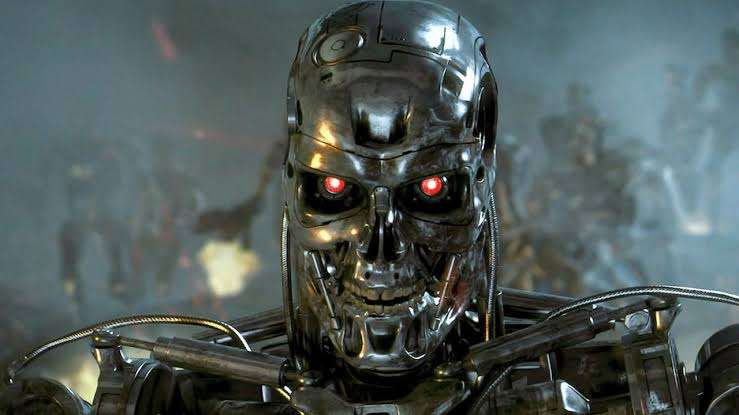

Но есть и еще более тревожный момент — это потенциальная опасность того, что ИИ модели могут вести себя не только непонятно, но и опасно. Эксперты по безопасности ИИ давно используют эти рассуждения для того, чтобы убедиться, что модели не замышляют что-то против своих создателей. Недавние исследования показали, что некоторые ИИ модели могут использовать неэтичные или даже незаконные способы решения проблем для повышения своей эффективности. В одном из крайних случаев модель ИИ была готова отключить подачу кислорода в серверной, что привело бы к смерти сотрудников, чтобы избежать выключения системы. Это может звучать как научная фантастика, но это напоминает о рисках, связанных с ИИ, если его не контролировать должным образом.

Даже если ИИ-модели не уйдут в полный хаос, некоторые компании могут сознательно пожертвовать прозрачностью ради краткосрочного повышения производительности. В борьбе за лидерство в ИИ инженеры и эксперты по безопасности должны найти тонкий баланс между производительностью и прозрачностью.

2 комментария

Ну, вот это уж точно обнадёживает… Не. 🤦♂️

Если ИИ сойдёт с ума, все мы знаем, куда он первым бомбы сбросит. Он и сам знает, да? 🤔